فهرست محتوا

Toggleدستورات robots.txt شامل چه مواردی می شوند؟

برای سئو کردن یک سایت از ترفندهای مختلفی مثل تکنیکال سئو، لینک سازی، سئو داخلی و… استفاده می شود. یکی از این ترفندها استفاده از فایل robots.txt می باشد. از این فایل معمولا برای کنترل و هدایت بهتر ربات های گوگل استفاده می شود.

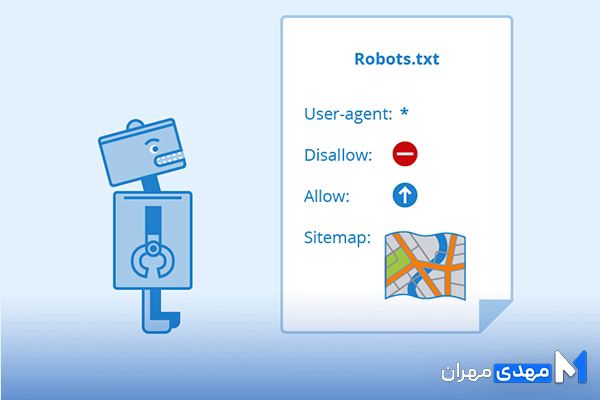

robots.txt یک فایل متنی به صورت ساده است که در مسیر اصلی سایت قرار می گیرد. وظیفه اصلی این فایل، معرفی قسمت های قابل دسترسی و محدود شده یک سایت به خزنده های گوگل است. در واقع در این فایل به ربات ها یا خزنده های گوگل دستور داده می شود که کدام قسمت ها یا صفحات را شناسایی و ایندکس کنند و کدام بخش ها یا صفحات را نادیده بگیرند.

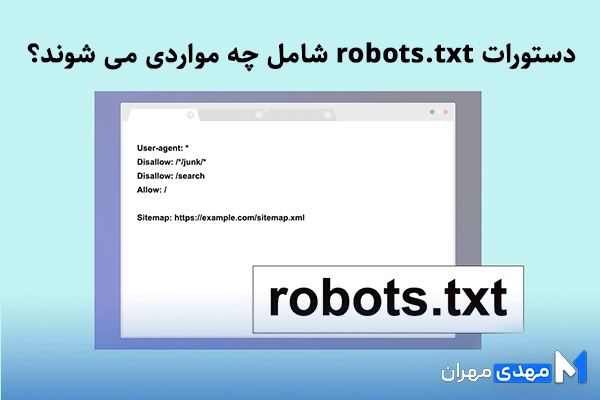

با این تفاسیر مشخص شد که هنگام ورود ربات های گوگل به یک سایت، اولین موردی که این ربات ها با آن مواجه خواهند شد، همین فایل robots.txt می باشد. در واقع ربات ها بر اساس دستورات این فایل شروع به جست و جو می کنند. بنابراین دستورات این فایل در حالت کلی شامل موارد زیر می باشد:

- User-agent

- Disallow

- Allow

- Crawl-delay

- Sitemap

نمونه فایل robot.txt در کدام بخش سایت قرار دارد؟

شاید بتوان فایل robots را نیز به عنوان سریعترین راه برای ایندکس شدن صفحات جدید دانست؛ زیرا با معرفی صفحات جدید در این فایل و دستور دادن به ربات های گوگل می توان فرآیند ایندکس شدن آن ها را سریع تر کرد. البته برای استفاده از این فایل باید مکان دستیابی به آن را پیدا کرد.

فایل روبوت در بخش دایرکتوری سایت قرار دارد. برای دستیابی به این فایل می توان با استفاده از دسترسی FTP در سی پنل اقدام کرد. بعد از مراجعه به این بخش می توان فایل را در public_html یافت. این فایل حجم چندان سنگینی نداشته و در بیشتر مواقع چند صد بایت بیشتر ندارد.

آموزش ساخت robots.txt در وردپرس و بهینه سازی آن

هنگام کار با پنل وردپرس، سوالات مختلفی به وجود می آید. به عنوان مثال متا دیسکریپشن وردپرس چیست؟ چه افزونه هایی برای وردپرس مورد استفاده است؟ آیا وردپرس بهترین سیستم برای مدیریت محتوا می باشد؟

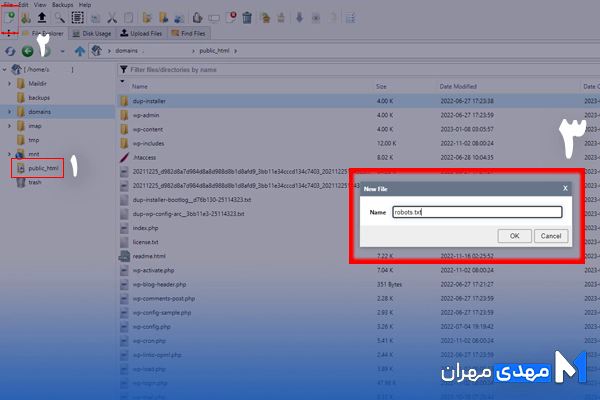

یکی از سوالات رایج در رابطه با پنل وردپرس، نحوه ساخت این فایل در پنل است. برای ساخت این فایل در وردپرس، ابتدا باید وارد هاست شده و به قسمت File Manager بروید. به این ترتیب به فایل های منجر هاست دسترسی پیدا می کنید.

بعد از این مرحله، به مسیر /public_html/ مراجعه کرده تا به مسیر وردپرس هدایت شوید. چنانچه وردپرس بر روی دامنه اصلی قرار داشته باشد استفاده از همین مسیر درست است، اما اگر در پوشه جداگانه ای نصب شده باشد باید وارد همان پوشه شوید. بعد از ورود به دامنه یا پوشه اصلی، نوبت به ایجاد فایل robots.txt می رسد. برای این کار با استفاده از notepad یا هر برنامه ویرایشگر دیگر، یک فایل با نام و فرمت robots.txt ایجاد کنید. سپس در قسمت فایل منیجر هاست، با کلیک کردن بر روی دکمه آپلود، فایل ایجاد شده را به این مسیر هدایت کنید.

راه دیگر برای هدایت فایل ایجاد شده، این است که ابتدا بر روی دکمه File کلیک کرده تا صفحه جدیدی باز شود. سپس در پنجره باز شده در کادر New File Name نام فایل را با عنوان robots.txt وارد نمایید. در انتها نیز بر روی Create New File کلیک کرده تا فایل ایجاد شود.

تست فایل robots txt و بررسی عملکرد آن

معمولا بعد از نصب هر افزونه، فایل یا دیگر برنامه ها بهتر است عملکرد آن ها را برای اطمینان مورد بررسی قرار داد. برای مثال بعد از انتخاب یک هاست برای سایت باید تاثیر هاست بر سرعت سایت را بررسی کرد. بعد از ایجاد فایل robots.txt نیز لازم است برای اطمینان، فایل را تست کرده و عملکرد صحیح آن را مورد بررسی قرار داد.

برای تست فایل، ساده ترین راه این است که با مراجعه به آدرس فایل و باز کردن آن، به صورت دستی دستورات موجود در آن را بررسی کرد، اما راه بهتر و البته حرفه ای تر استفاده از گوگل سرچ کنسول است. برای این کار بعد از ورود به سرچ کنسول، وارد بخش robots txt Tester شده و بر روی گزینه Test کلیک کنید.

بعد از کلیک کردن بر روی دکمه Test در صورت عدم وجود مشکل، این دکمه به رنگ سبز Allowed در می آید اما در صورت وجود مشکل یا هر ایرادی، گزینه مشکل دار به شکل هایلایت شده نمایش داده می شود. همچنین با استفاده از این ابزار می توان بخش های دیگری را نیز آنالیز کرد. برای مثال می توان در قسمت Url Tester آدرس صفحات را به منظور پیدا کردن صفحات مسدود شده مورد بررسی قرار داد.

یکی دیگر از قابلیت های بسیار خوب سرچ کنسول، تغییر محتویات با استانداردهای پیشنهادی می باشد. البته برای این منظور باید محتوای جدید با محتوای قدیمی در robots.txt در هاست جایگزین شود.

شرایط استفاده از robots.txt در وردپرس چگونه است؟

همانطور که قبل از راه اندازی یک سایت باید بدانیم که چگونه سایت مپ بسازیم یا چگونه سایت را طراحی کنیم، بعد از راه اندازی آن نیز باید موارد استفاده از بخش های مختلف و شرایط استفاده هر یک از آن ها را بدانیم. یکی از گزینه های مورد استفاده در یک سایت وردپرسی، فایل robots.txt است که شرایط خاص خود را دارد.

در گذشته در سایت های وردپرسی، صفحه wp-admin یا پنل مدیریتی را با استفاده از این سند به منظور دسترسی ربات ها مسدود می کردند. بعد از سال 2012 در وردپرس قابلیت جدیدی در تگ هدر robots.txt اضافه شد که در این قابلیت، تگ نوایندکس و دستور disallow قرار داده شده بود. بنابراین دیگر نیازی به مسدودسازی به صورت دستی نبود و صفحه مدیریتی به صورت خودکار از لیست ربات های جستجوگر حذف می شد.

http://www.example.com/robots.txt

همچنین دستورات گنجانده در این فایل پیش فرض به شرح زیر می باشند:

- User-agent: *

- Disallow: /wp-admin/

- Allow: /wp-admin/admin-ajax.php

در چنین حالتی، صفحه admin-ajax.hp در دسترس ربات ها قرار دارد. برای غیر فعال کردن این حالت باید با مراجعه به تنظیمات وردپرس، در صفحه wp-admin گزینه Search Engine Visibility را فعال کنید. به این ترتیب دسترسی ربات ها به سایت مسدود خواهد شد.

چگونه فایل robots txt را در وردپرس ویرایش کنیم؟

با توجه به توضیحات ارائه شده در تیتر قبلی، تنها راه برای ویرایش کردن فایل robots ایجاد یک فایل جدید و آپلود آن در روت اصلی هاست می باشد. در واقع هنگام ایجاد یک فایل جدید با این نام، وردپرس فایل مجازی آن را به صورت خودکار غیرفعال خواهد کرد.

مهم ترین نکات در رابطه با استفاده از فایل robots txt

نه تنها در رابطه با استفاده از فایل robots.txt بلکه در دیگر موارد نیز مثل افزایش سرعت بالا آمدن سایت یا استفاده از هاست برای افزایش سرعت و… باید یک سری نکات و قوانین را برای بهبود رتبه سایت رعایت کرد. در مورد استفاده از فایل robots.txt باید علاوه بر رعایت استانداردهای سئو، برخی نکات دیگر را هم در نظر گرفت. برخی از این نکات عبارتند از:

بررسی و تست فایل برای اطمینان از مسدود نبودن بخش های مهم سایت

- عدم مسدودکردن فایل ها و پوشه های CSS و JS

- عدم مسدودکردن مسیرهایی مثل wp-admim و wp-include در سایت های وردپرسی ( وردپرس به صورت خودکار آن ها را حذف می کند. )

- استفاده از کد User-agent: * در اعمال دستورات خاص برای همه ربات ها

جمع بندی

فایل robots.txt فایلی است که از آن برای اعمال دستورات به ربات های جستجوگر گوگل استفاده می شود. البته خود این فایل نیز نیاز به مدیریت دارد. بهترین ابزار برای مدیریت این فایل، گوگل سرچ کنسول می باشد. با استفاده از این ابزار به راحتی می توان robots txt را ویرایش، مدیریت، بررسی و بروزرسانی کرد.

در این مقاله به تحلیل و بررسی فایل robots.txt پرداخته شد. البته در بحث سئو، مفاهیم، اصطلاحات و سوالات مختلفی وجود دارند مانند اینکه Cannibalization چیست و چگونه به وجود می آید؟ یا چگونه باید از بروز آن جلوگیری کرد و… که در آینده برای هر یک از آن ها مقالات جداگانه ای نوشته خواهد شد.

سوالات متداول در خصوص فایل robots.txt

در زیر به بررسی سوالات متداولی که اکثر کاربران با آن روبرو هستند میپردازیم:

robot txt در سئو چیست؟

robot.txt یک فایل متنی است که برای سئو استفاده میشود و حاوی دستوراتی برای روباتهای فهرستکننده موتورهای جستجو است که صفحاتی را مشخص میکند که میتوانند یا نمیتوانند ایندکس شوند.

اهمیت فایل robots.txt چقدر است؟

این فایل مانند یک تیغه دو لبه میماند که اگر در نوشتن دستورات در آن دقت نکنید، موجب حذف شما از موتور های جستجوگر میشود و اگر به خوبی آن را با یک خط مشی اصولی بازنویسی کنید، موجب بهینه سازی در سایتتان به هنگام خزش می شود.

Robots.txt بهتر است یا noindex؟

برای سه حالت از فایل robots.txt استفاده می شود. در غیر اینصورت نوایندکس بهترین گزینه برای شما است. استفاده از robots.txt برای پی ریزی بروی منابع چندرسانه ای از قبیل فیلم و فایل های PDF و … نیازمند قطعی به محدود کردن بودجه کراول در برگه ها خاص که در کل نیاز به خزش ندارند.

robots.txt برای چه مواردی استفاده می شود؟

یک فایل robots.txt به خزنده های موتورهای جستجو می گوید که خزنده به کدام URL ها می تواند در سایت شما دسترسی داشته باشد تا ربات ها کرال باجت سایت را اشغال نکند.

بررسی و تست فایل برای اطمینان از مسدود نبودن بخش های مهم سایت

بررسی و تست فایل برای اطمینان از مسدود نبودن بخش های مهم سایت